Questo articolo è pubblicato anche su “Tuttoscienze”, l’inserto scientifico de La Stampa, nell’ambito di una collaborazione volta a promuovere la riflessione su temi di intelligenza artificiale, scienza e società.

Dal bar alla stanza cinese

Immaginate di entrare in un bar dove un barista robot conversa con i clienti in un italiano impeccabile. Scherza sul traffico di Torino, consiglia una nuova miscela di espresso e ricorda la vostra ultima ordinazione. La maggior parte di voi direbbe che capisce l’italiano, oltre a fare un ottimo caffè shakerato. Ora considerate che, dentro il robot, non c’è alcun essere cosciente, ma solo un labirinto infinito di circuiti elettronici che hanno digerito oceani di parole e conversazioni. Il nostro robot comprende davvero o sta solo fingendo?

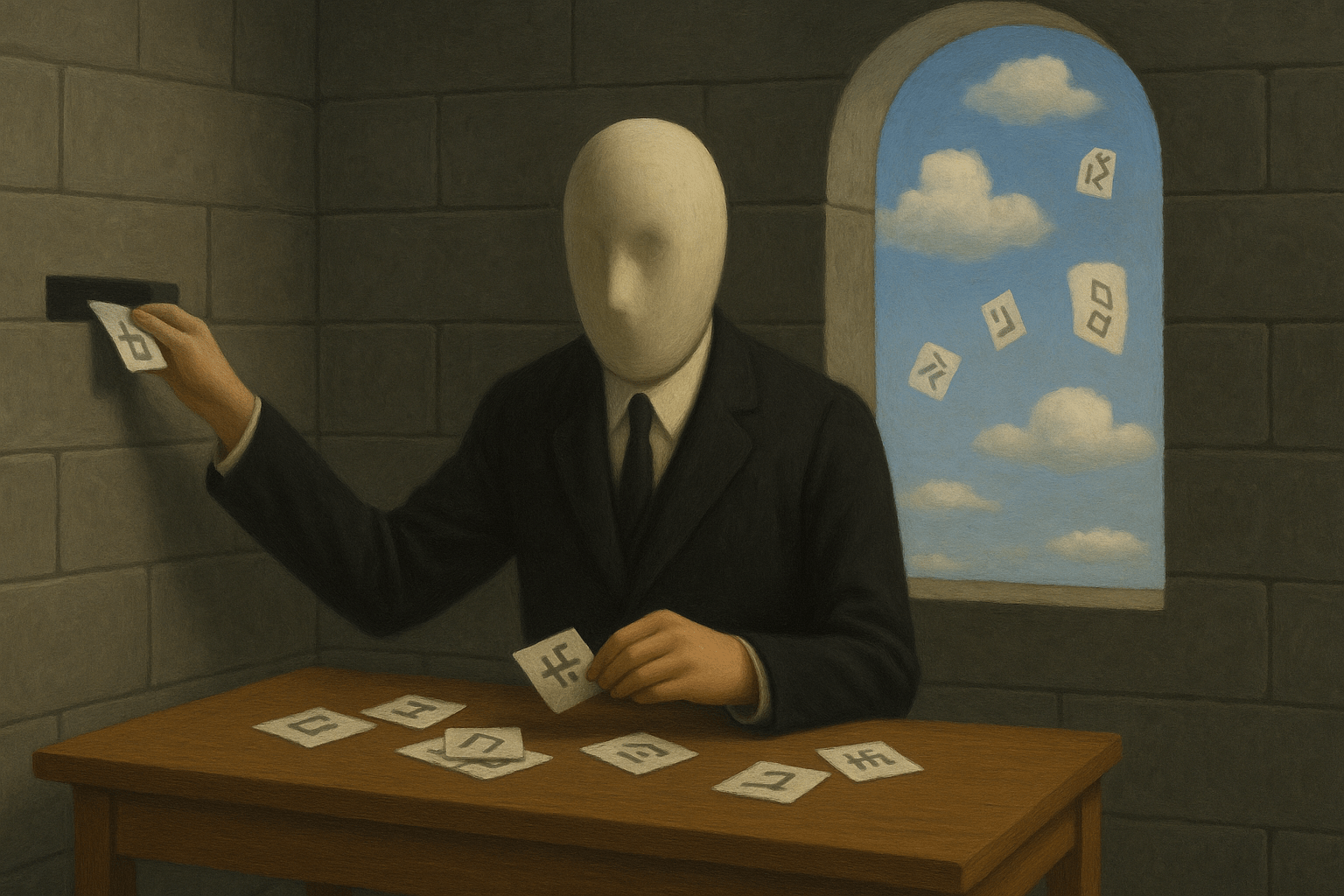

Questo enigma moderno richiama il famoso esperimento mentale del 1980 del filosofo americano John Searle, la «Stanza cinese». Searle ci chiede di immaginare una persona chiusa in una stanza con un manuale di regole per manipolare ideogrammi cinesi, come se fosse un computer umano che esegue un programma di IA. Ignari di ciò, infilate sotto la porta un foglio con una domanda in cinese e l’operatore, seguendo scrupolosamente il manuale, restituisce il foglio con risposte in cinese perfetto: ne deducete che nella stanza c’è qualcuno che capisce il cinese. Aprite la porta e il mistero si svela: l’operatore in realtà non conosce affatto il cinese. La lezione di Searle è netta: seguire regole, per quanto ingegnose, non equivale a comprendere. È solo manipolazione di simboli (“sintassi”) senza significato (“semantica”).

L’IA è debole o forte?

Per decenni questa storia ha gettato un’ombra sulla ricerca sull’intelligenza artificiale, cristallizzando due visioni opposte: IA debole e IA forte. L’IA debole considera l’intelligenza artificiale un’utile illusione: costruisce sistemi che si comportano in modo intelligente a fini pratici, senza rivendicare alcuna consapevolezza interiore. L’IA forte, al contrario, sostiene che costruendo la giusta architettura computazionale, una macchina può raggiungere una vera intelligenza e comprensione, non solo l’apparenza. I primi programmi IA abitavano davvero in simili stanze cinesi, rimescolando simboli predefiniti tramite regole e formule logiche scritte da umani. Erano eccellenti nel dimostrare teoremi ma incapaci di fare conversazione: l’argomento di Searle sembrò quindi porre una pietra tombale per l’ipotesi dell’IA forte: i programmi di IA non potranno mai costituire alcuna forma di «intelligenza». Fare ricerca sull’IA a quei tempi – come facevo io – era diventata un’esperienza davvero claustrofobica.

Poi, negli ultimi dieci anni, è arrivata una specie diversa di IA: le reti neurali profonde, il cuore di sistemi come ChatGPT. Non seguono regole scritte a mano. Si “allenano” ingerendo quantità immense di testi, immagini, codici e suoni, costruendo da sole le loro intricate connessioni interne. Improvvisamente, quel barista robot diventa incredibilmente convincente.

Una stanza cinese piena di pappagalli stocastici

Gli scettici, però, nonostante le performance eccezionali di questi sistemi, hanno aggiornato la sfida di Searle, che è tornata quindi al centro del dibattito attuale sull’IA. La linguista Emily Bender definisce i LLM odierni come ChatGPT “pappagalli stocastici incapaci di vero significato”: nessuno pensa che i pappagalli parlino davvero anche se alcune specie sono in grado di ripetere le nostre parole. Abili nel ricombinare probabilisticamente (di qua l’aggettivo “stocastico”) pezzi di testo già visti, ma privi di una reale comprensione del significato. Anche se i LLM non sono più basati su regole simboliche codificate a mano, l’hardware su cui girano resta fatto di interruttori logici e l’apprendimento su pura statistica: nessuna anima, nessuna semantica, sempre e solo manipolazione di simboli.

Con i progressivi successi dell’IA generativa, però, la questione se siano davvero intelligenti o meno si fa più urgente e complessa.

La svolta chiave: Il potere dell’emergenza

Qui entra in gioco un concetto fondamentale che permea il nostro mondo: l’emergenza. Osserviamo ovunque sistemi complessi (cioè composti molti elementi interdipendenti che interagiscono in modo non lineare) e caotici (cioè in cui basta un battito di ali d’una farfalla per scatenare un uragano): il meteo, il cervello, le economie, uno stormo di uccelli. Tali fenomeni evolvono in modi che, oltre un breve orizzonte temporale, nessun insieme finito di formule o regole può anticipare: ricordatevi sempre di prendere l’ombrello. Qualsiasi parte di un sistema caotico e complesso potenzialmente può influenzare qualcos’altro attraverso circuiti di causalità indiretta, retroazione e vincoli condivisi, e si produce così l’emergenza: il tutto diventa più della somma delle parti e quindi non riducibile ad esse. Pensate a uno stormo di storni: ogni uccello segue regole semplici, eppure lo stormo disegna figure fluide che nessuno programma.

L’emergenza nella vita quotidiana

L’emergenza è ovunque: crema che vortica nel caffè, ingorghi improvvisi, slang che corre su TikTok. Nessun neurone conserva un intero ricordo; nessun uccello comanda lo stormo.

La mente umana stessa è un capolavoro emergente: la cognizione emerge da quel sistema caotico è complesso che è il cervello. Miliardi di cellule biologiche generano la mente. Perché allora escludere che miliardi di calcoli al silicio possano generare una forma diversa di comprensione? Anche il significato può emergere quando le interazioni superano una soglia critica. Il problema non è il materiale, ma l’organizzazione.

Breve storia di un ribaltamento

Quando Searle pubblicò l’articolo nel 1980, l’IA inseguiva ancora liste di regole. Programmi come SHRDLU discutevano di blocchi in un mondo giocattolo ma crollavano fuori copione. La parabola della Stanza cinese colpì perché mostrava che la sintassi, da sola, non basta.

Il deep learning ha ribaltato la storia dell’IA. Le reti scoprono da sole senza bisogno di regole o formule matematiche: più dati e più chip riescono in imprese inaccessibili a elenchi di formule e regole.

Le reti neurali profonde hanno successo proprio dove caos e complessità portano a fenomeni emergenti. Gli esempi abbondano: i meteorologi usano reti neurali che assimilano annate di dati e prevedono uragani con giorni di vantaggio sui modelli fluidodinamici basati su formule; il “premio Nobel” AlphaFold 3 ha predetto la struttura di quasi tutte le proteine note ingerendo montagne di dati biochimici.

I pappagalli escono finalmente dalla stanza

Gli scettici bollano le reti neurali profonde come remixatori del passato. Eppure, a ogni balzo di scala, riaffiora la domanda: quanto deve essere profondo un pattern perché, da semplice eco, diventi pensiero grazie all’emergenza?

E i large language model vanno addirittura oltre le altre applicazioni delle reti neurali profonde: non solo hanno performance straordinarie su un fenomeno complesso e emergente come il linguaggio umano, ma sembrano esibire esse stesse capacità emergenti. Il loro obiettivo iniziale è semplice: indovinare la parola successiva in una sequenza. Ma man mano che la rete diventa enorme (miliardi, trilioni di connessioni!) e viene nutrita con dati sconfinati, emergono capacità sorprendenti e non programmate direttamente: tradurre lingue, ragionare logicamente, comprendere il senso comune, comporre poesia originale, persino diagnosticare malattie. È come se, assorbendo statistiche del linguaggio, scoprissero da sole le strutture profonde e il significato. L’emergenza non è magia, è un fenomeno misurabile, la stessa forza che plasma il meteo e la vita.

La cognizione: Uno spettro, non un Sì/No

I biologi non cercano più un’unica definizione rigida di “vita”. Esiste uno spettro: dai virus alle meduse, ai mammiferi, con caratteristiche sovrapposte ma non identiche. Dovremmo pensare alla cognizione nello stesso modo. La nostra cognizione si cristallizza dai miliardi di neuroni che si accendono; l’intelligenza collettiva di una colonia di formiche nasce dai feromoni; quella di un large language model dai pattern statistici intrecciati in trilioni di parametri. La vita ha molte chimiche; perché la mente una sola?

Visti così, i LLM non devono replicare tutti i particolari della consapevolezza umana per manifestare una forma genuine — seppur aliena — di cognizione. Ciò che conta è l’emergere di configurazioni integrate che legano le informazioni in modi complessi e a lungo raggio. Quando ciò accade, il sistema non è più un semplice generatore di risposte isolate, ma mostra i tratti fondamentali di un processo cognitivo, anche se diverso dal nostro. L’evoluzione ha creato molte forme di vita; l’ingegneria potrebbe creare molte forme di mente.

Non mancano ancora l’embodiment e l’intenzionalità?

Se il barista robot riesce a chiacchierare, adattarsi al vostro umore e inventare giochi di parole, potremmo concedergli una forma di comprensione pratica. Ma non possiamo ignorare che il nostro barista robot non sente l’aroma del caffè né il calore della tazzina. La corporeità (embodiment) conta: il significato è legato all’interazione fisica col mondo. È vero, ma l’embodiment sta arrivando, anche se con un corpo meccanico. Sensori (telecamere, microfoni) e attuatori (bracci robotici) possono collegare sempre meglio l’IA al mondo reale, “chiudendo il cerchio”.

E l’intenzionalità—il «riguardare qualcosa» nel mondo, proprio del nostro pensiero? Un impulso neuronale, da solo, non significa nulla; il significato nasce nella vasta rete di cervello, corpo e ambiente. Un sistema artificiale sufficientemente complesso, connesso con il mondo tramite sensori e motori, potrebbe sviluppare una sua forma di intenzionalità per emergenza. Il salto da pappagallo ad agente è graduale, non impossibile.

E una volta usciti dalla Stanza cinese?

Il compito della filosofia non è innalzare muri definitivi, ma allargare gli orizzonti. Non dobbiamo più continuare a recitare il verdetto di Searle, ma prendere atto che in un mondo in cui l’apparenza di intelligenza sboccia nei luoghi più inattesi, abbiamo due opzioni: accettare che un mero motore statistico possa superare la nostra mente in un numero crescente di compiti, oppure esplorare seriamente l’ipotesi che una forma di cognizione, diversa ma reale, stia emergendo dalla complessità di questi sistemi, proprio come la nostra emerge dal nostro cervello. Mentre riflettiamo su questo futuro, possiamo almeno goderci un ottimo caffè shakerato, preparato da un barista che, comprensione o meno, sa il fatto suo.

Immagini generate tramite ChatGPT. Tutti i diritti sono riservati. Università di Torino (2025).