Si moltiplicano nelle assemblee legislative (Parlamento Europeo, parlamento italiano, ecc.) le promulgazioni di corpi legislativi (AI Act, legge 132/2025) che faticosamente disciplinano la regolamentazione (governance), la valutazione, i diritti fondamentali e il sanzionamento dell’Intelligenza Artificiale Generativa. L’impresa appare ai più ardua e non manca chi definisce l’AI Act un “mostro giuridico” e la nuova tecnologia ad “alto rischio” (G. SARTOR, L’intelligenza Artificiale e il diritto).

La poliglossia delle nuove normative di IA

Va rilevato, inoltre, che nella fattispecie il linguaggio giuridico e per certi versi quello accademico sono artificiosamente ridondanti di neologismi, anglicismi, ecc. Gli agenti digitali robotici sono denotati con un eccesso di connotazioni, talvolta astratte e prive di pragmatismo, che ne regolano le diverse funzioni (consenso informato, responsabilità professionale, tracciabilità decisionale, supervisione, validazione dei suggerimenti algoritmici, audit clinico, liminalità, human agency, safety, privacy, non-discrimination, fairness, accountability, accuracy, transparency, compliance, robustsness, cibersecurity, explanation, ecc.). Questa ipertrofica poliglossia non è di secondaria importanza e merita un giusto approfondimento. Il legislatore è ben consapevole che la nuova tecnologia è ancora incompiuta e applicabile con ‘molti rischi’ e, pertanto, si preoccupa preventivamente di mitigarne gli effetti avversi. Per parafrasare l’affermazione di Ludwig Wittgeinstein “i limiti del mio linguaggio rappresentano i limiti del mio mondo” (L. WITTGEINSTEIN, Tractatus Logico-Philosophicus) potremmo equivalentemente affermare “la poliglossia del mio linguaggio rappresenta la complessità/vulnerabilità del mio mondo”. L’IA di matrice Californiana sta colonizzando i sistemi sanitari, gli studi medici, le università di medicina, i malati bisognosi di diagnosi, terapie, cure, che si affidano alle piattaforme sanitarie, ecc. Ci fidiamo acriticamente del ciberspazio cognitivo dell’IA, progettato e posseduto dai pochi technosapientes, che hanno profilato le nostre malattie, le nostre patologie, e ci propongono cure e terapie in strutture sanitarie privilegiate dagli algoritmi di machine learning o ci suggeriscono farmaci utili alla cura di case farmaceutiche in combutta con la proprietà del software, perché riferibili allo stesso pacchetto azionario societario. Una normale sessione su un qualsiasi software di IA, in cui l’utente confida un suo problema di salute è pilotata dall’algoritmo attraverso domande successive, miranti a conoscere con controdomande molto cortesi, la sua localizzazione per suggerire un presidio sanitario, un farmaco, o altra proposta commerciale. Il sintagma conclusivo di ogni risposta del prompt ai nostri quesiti in materia sanitaria è sistematicamente la formulazione di una controdomanda, che ha lo scopo di alimentare la discussione e di orientarla verso una proposta di acquisto. Non vi sorge il dubbio che il fine occulto della nuova tecnologia, detenuta da pochi eletti (Big tech), proprietari dei nostri dati sanitari in forma secondaria e, talvolta anche con l’identificazione primaria, perché acquisita con frode tramite il mercato del cybercrimine, sia l’imposizione di un brand commerciale sanitario? E che sarà del nostro fascicolo elettronico quando la nostra privacy sarà violata e i nostri dati sanitari saranno venduti al migliore offerente? Saremo inondati sui nostri dispositivi digitali da proposte commerciali relative alle nostre patologie?

La sanità assistita dall’IA: un utile passo in avanti?

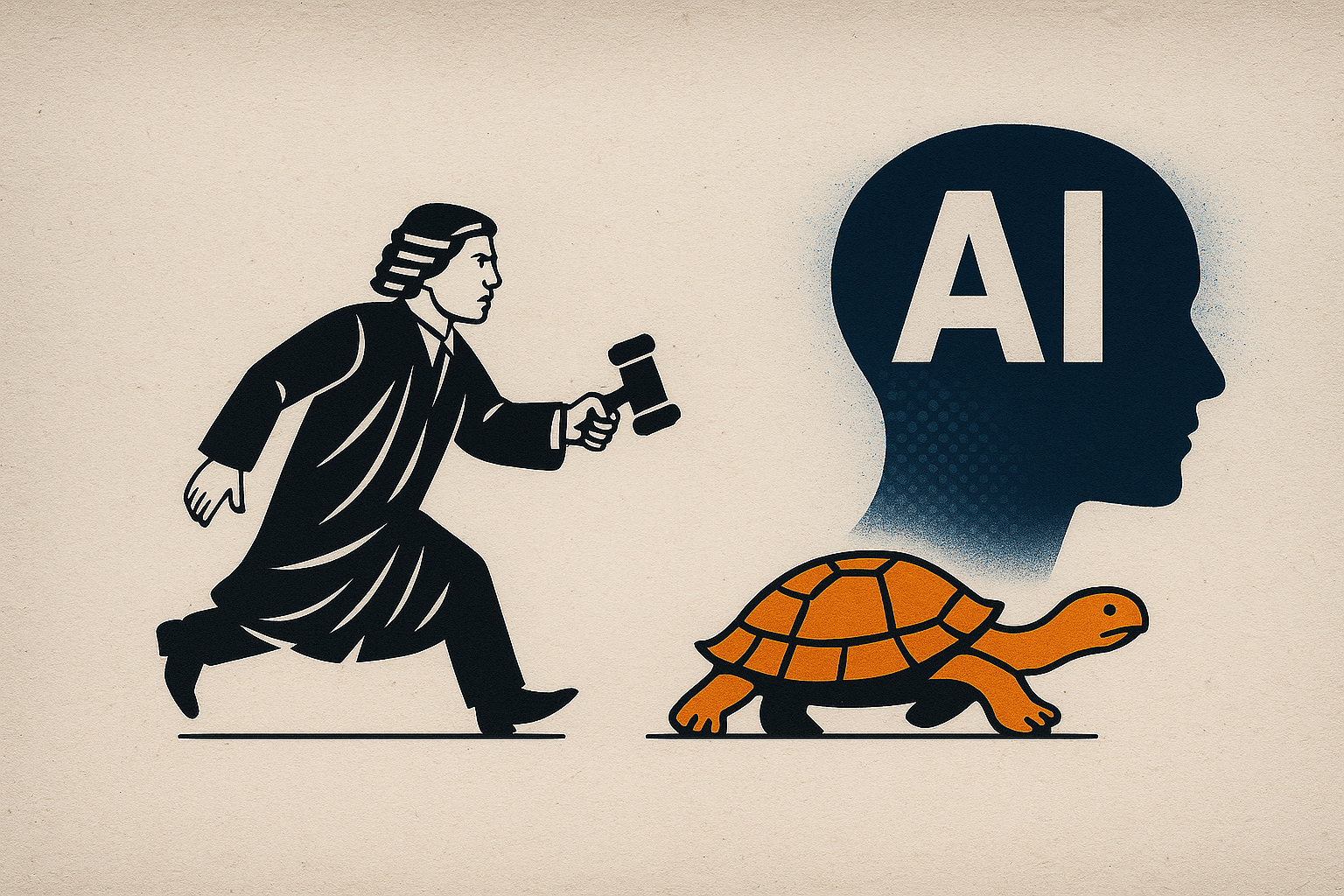

In questa situazione la promulgazione di pletorici corpi normativi sull’IA, col fine di regolare la nuova tecnologia, rischia di essere una pura illusione come mostra il noto paradosso di Zenone (Achille e la tartaruga). Nel momento in cui il ‘mostro giuridico’ (AI Act/Achille) parte dopo il suo concorrente (agente digitale robotico/tartaruga) quest’ultimo non sarà mai raggiunto, perché sarà sempre un po’ più avanti dell’inseguitore. Per dirla alla Floridi il ‘gap di responsabilità’ tra il diritto umanitario internazionale e l’etica insieme al conseguente disallineamento tra la responsabilità morale e quella giuridica dovrebbero riflettere la natura distribuita del processo decisionale dell’IA (L. FLORIDI, La differenza fondamentale. Artificial Agency: una nuova filosofia dell’Intelligenza Artificiale).

Negli agenti digitali robotici la filiera della decisione è opaca, difficilmente decifrabile, anche da esperti del settore, e non assicura l’allineamento tra la responsabilità morale e quella giuridica. Con buona pace di tanti meritevoli ed encomiabili medici una sanità assistita da software di IA, il cui assetto proprietario è detenuto da cinici multimiliardari, che perseguono il capitalismo della sorveglianza sanitaria per accrescere il loro patrimonio, è destinata a soccombere al paradosso di Zenone. I tanti volenterosi medici (che non a caso la norma chiama deployer, derivato dal latino displicare, dove il prefisso dis significa ‘separare’ e il suffisso plicare significa ‘piegare’) in una sanità assistita dall’IA e regolata dalla legge 132/2025 dovranno gravosamente sbrogliarsi da questo ulteriore gravame per potersi dedicare con senso di responsabilità alla cura del malato. Essi non solo risponderanno sotto il profilo penale e civile dell’atto medico assistito dall’IA, ma in più saranno gravati di nuove e più complicate incombenze: consenso informato, sorveglianza, validazione, audit clinico e tracciabilità decisionale dell’algoritmo, del quale non conoscono, a motivo della tutela del brevetto, le specifiche del codice sorgente e non conoscono con quali dati è stato addestrato. Tutto questo non condurrà all’adozione di una medicina ancor più difensiva? Non si rischia in futuro di ostacolare il rapporto tra medici e malati in una sanità pubblica e/o privata assistita da un’IA che ha il suo domicilio nella Silicon Valley? E i pazienti da chi, come e quando saranno alfabetizzati, per districarsi tra consensi informati, diagnosi e terapie assistite dall’IA? In questo scenario, delegando la gestione del consenso informato alle chatbot, siamo sicuri di aver fatto un utile passo in avanti se, anche di poco, chi lucra sulla salute è già oltre le nostre tante buone intenzioni?

Riferimenti bibliografici

G. SARTOR, L’intelligenza Artificiale e il diritto, Giappichelli, Torino 2022.

L. PERISSINOTTO – P. FRASCOLLA (EDD.), L. WITTGEINSTEIN, Tractatus Logico-Philosophicus, Feltrinelli, Milano 2022

L. FLORIDI, La differenza fondamentale. Artificial Agency: una nuova filosofia dell’Intelligenza Artificiale, Mondadori, Milano 2025.

Immagini generate tramite ChatGPT. Tutti i diritti sono riservati. Università di Torino (2025).