In questo momento storico segnato da una crescente policrisi globale, l’Intelligenza Artificiale (IA) sembra affermarsi come il nuovo regime di conoscenza in grado di trasformare il mondo. Questo discorso si è intensificato con l’arrivo, nel 2022, di ChatGPT e di altri sistemi generativi, che hanno introdotto un cambiamento radicale nel modo in cui l’IA interagisce con persone, società e istituzioni. Tuttavia, come sostiene Dan McQuillan nel suo libro Resisting AI, l’IA non è soltanto un insieme di tecniche di machine learning (ML): “L’IA non è mai separata dall’insieme di dispositivi istituzionali che devono esistere affinché essa abbia un impatto sulla società.” L’IA è dunque un ‘apparato’—una configurazione stratificata e interdipendente di tecnologie, istituzioni e ideologie. Questo apparato non esiste separatamente dal mondo sociale, ma si intreccia con esso, rafforzando spesso le contraddizioni e le crisi che caratterizzano i nostri tempi post-normali.

Per questo motivo, parlare di IA significa riconoscere che, come ogni altra tecnologia, essa non è neutrale, ma incorpora relazioni sociali, valori, pregiudizi, politiche e dinamiche di potere. L’IA è un artefatto tecno-politico e un assemblaggio socio-tecnico di tecniche, motivazioni e ideologie. Si tratta di un aspetto cruciale da tenere in considerazione per chi opera nel campo dello sviluppo e cooperazione internazionale e dell’azione umanitaria. Inoltre, i sistemi di IA non nascono nel vuoto: la loro progettazione e diffusione sono profondamente radicate in contesti storici, culturali e politico-ideologici. Come ricorda Matteo Pasquinelli nel suo libro The Eye of the Master, le idee di Friedrich Hayek sull’ordine spontaneo e l’auto-organizzazione del mercato hanno influenzato lo sviluppo iniziale dell’IA connessionista. Frank Rosenblatt, che nel 1958 sviluppò il Perceptron—la prima rete neurale artificiale operativa per il riconoscimento di pattern—citava esplicitamente i lavori di Hebb e di Hayek come fondamenta teoriche.

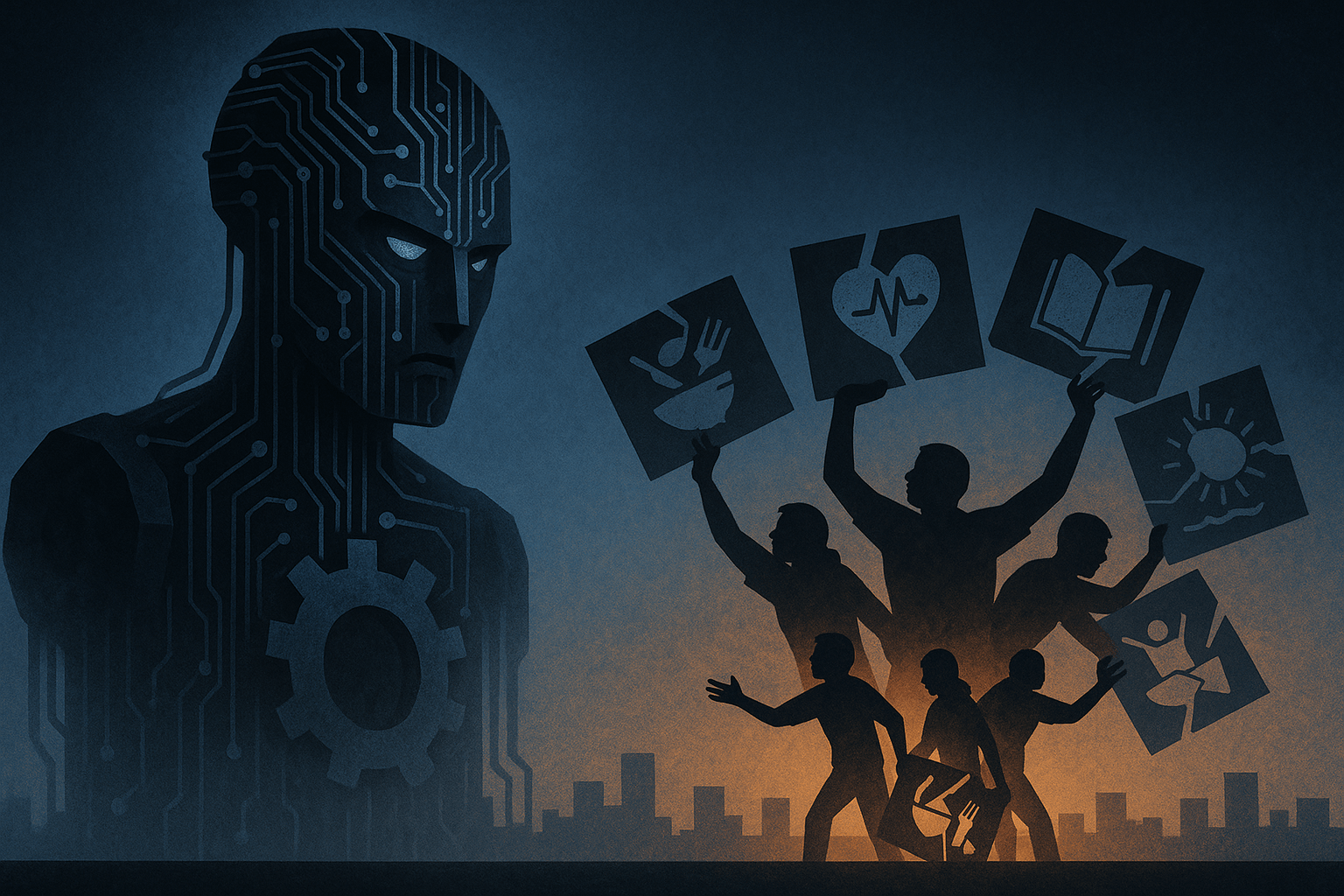

L’incompatibilità tra IA e principi umanitari

È in questo contesto che la domanda cruciale posta da Langdon Winner—“Gli artefatti hanno una politica?”—acquista una rinnovata attualità. Secondo Winner, le configurazioni tecniche possono perpetuare o mettere in discussione gli assetti sociali, producendo spesso esiti che favoriscono alcuni interessi a scapito di altri. Nei contesti di sviluppo e intervento umanitario, dove l’IA viene frequentemente presentata come soluzione a problemi complessi, questa prospettiva critica diventa ancora più rilevante. La politica incorporata nei sistemi di IA si scontra frontalmente con i principi fondanti dell’azione umanitaria: umanità, imparzialità, neutralità e indipendenza. Nella pratica, i sistemi di IA sono in gran parte controllati e governati da un ristretto gruppo di grandi aziende tecnologiche private, i cui modelli di business si basano su logiche di sorveglianza, estrazione di dati e profitto—strutture radicalmente incompatibili con l’etica umanitaria.

Inoltre, i sistemi di IA tendono spesso a disumanizzare, a oscurare la responsabilità, e a perpetuare bias sistemici. Non si tratta di malfunzionamenti accidentali, bensì di sintomi strutturali di conseguenze più ampie: l’appropriazione dello sviluppo digitale da parte di interessi aziendali, l’opacità dei processi algoritmici e il riemergere di dinamiche coloniali nel dominio digitale, come evidenziato da una ricerca recente. Questi esiti sono caratteristiche strutturali del modo in cui l’IA viene concepita, finanziata e implementata. Di fronte a queste dinamiche, è necessaria un’interrogazione urgente, sistemica e critica da parte degli attori dello sviluppo e dell’umanitario—non un audit tecnico, ma un confronto politico ed etico sul futuro che vogliamo per la tecnologia.

Nonostante venga spesso presentata come rivoluzionaria, l’IA fatica a tradursi in progressi concreti verso il raggiungimento degli Obiettivi di Sviluppo Sostenibile (SDGs). Gli SDGs—che rappresentano forse l’unico consenso globale su cosa dovrebbe essere il “bene comune”—stanno conoscendo per la prima volta una fase di stallo o addirittura di regressione. Secondo i rapporti sugli SDGs del 2022, 2023 e 2024, una serie di crisi interconnesse—pandemia da COVID-19, cambiamenti climatici, conflitti armati—ha cancellato anni di progressi. Il rapporto del 2022 ha evidenziato gravi battute d’arresto nell’eliminazione della povertà e della fame, nel miglioramento della salute e dell’istruzione, e nell’accesso ai servizi essenziali. Nel 2023, circa la metà dei 140 obiettivi misurabili mostrava deviazioni moderate o gravi rispetto ai traguardi previsti. Peggio ancora: oltre il 30% degli obiettivi non mostrava alcun progresso, o era regredito al di sotto dei livelli del 2015.

Tutto questo accade nonostante l’accelerazione dell’IA e di altre tecnologie emergenti. Non è forse questo il paradosso dei paradossi: le promesse dell’innovazione crescono in modo esponenziale, mentre gli indicatori del benessere umano e planetario vacillano—o addirittura regrediscono?

L’IA come paradosso dei paradossi

I pericoli — e i paradossi — dell’IA emergono in modo particolarmente evidente nel suo impiego simultaneo in contesti di potere e vulnerabilità radicalmente diversi. Prendiamo ad esempio OpenAI: un’azienda le cui tecnologie vengono sempre più adottate da agenzie umanitarie e di sviluppo, ma che è al contempo sempre più intrecciata con interessi militari. Nel 2024, OpenAI, in collaborazione con Microsoft, è stata incaricata dal Comando Africa delle Forze Armate statunitensi (AFRICOM) di fornire capacità di IA per scopi di difesa—rafforzando il nesso tra tecnologia e militarizzazione. Nello stesso tempo, i modelli di OpenAI sono utilizzati dall’International Rescue Committee per sviluppare strumenti educativi alimentati da IA in contesti umanitari. Questa dualità rappresenta il paradosso dei paradossi: lo stesso apparato infrastrutturale viene impiegato tanto per scopi bellici quanto per interventi umanitari. Tali contraddizioni non sono marginali — sono al centro dell’apparato tecno-politico dell’IA. Sfide come queste mettono in discussione le nostre presunzioni di neutralità, etica e solidarietà negli interventi tecnologici, e costringono gli attori dello sviluppo a interrogarsi su chi controlla l’IA, chi ne trae beneficio e chi viene escluso.

Un altro rischio critico oggi è rappresentato dal potere seduttivo—o persino iper-persuadente—dei sistemi di generazione aumentata da recupero (Retrieval-Augmented Generation, RAG). Questi strumenti promettono a ONG e agenzie umanitarie risultati rapidi, sintetizzando grandi volumi di dati e generando risposte in tempi brevi. Tuttavia, questa apparente efficienza nasconde problemi strutturali: inaccuratezze nei dati, bias nei materiali di addestramento, e una generale insensibilità al contesto e alle esperienze vissute dalle persone. Le organizzazioni rischiano di cadere nella trappola del RAG, attratte dalla comodità e dall’efficienza economica, mentre trascurano il ruolo critico delle ONG nel promuovere processi democratici, solidarietà e giustizia sociale. Un esempio emblematico è quello di Save the Children, che sta sviluppando un chatbot basato su IA generativa chiamato “Ask Save the Children”, progettato per fornire orientamenti sulla protezione dell’infanzia recuperando e generando informazioni da un corpus curato di documenti.

Sebbene strumenti come questo possano offrire supporto ad operatori, genitori e bambini, pongono anche un dilemma cruciale: decisioni e indicazioni vengono sempre più delegate ad agenti algoritmici addestrati su dataset statici. Inoltre, come avviene in molti ecosistemi basati su tecnologie RAG, questo tipo di strumenti manca di meccanismi trasparenti per gestire la complessità, la conoscenza in evoluzione e i disequilibri di potere tra utenti e sviluppatori del sistema. Il problema si aggrava quando tali chatbot vengono pensati per contesti ad alto rischio e vulnerabilità, come disastri naturali o zone di conflitto. In questi scenari — dove gli errori di comunicazione possono avere conseguenze gravi — i limiti di sistemi di IA pre-addestrati diventano ancora più critici. Tali applicazioni richiedono un esame accurato della loro adeguatezza, adattabilità a contesti instabili e diversificati, e coerenza con i principi umanitari fondamentali.

Intelligenza umana collettiva, non intelligenza artificiale

Esistono tuttavia casi in cui l’IA — e in particolare il machine learning (ML) — è stata impiegata in modo responsabile e di supporto, a condizione che non venga presentata come una panacea, ma come uno strumento tra molti, inserito all’interno di sforzi sociali più ampi guidati dalle persone sul campo. Il lavoro del Distributed AI Research Institute (DAIR) in Sudafrica ne è un esempio significativo. In uno studio sull’apartheid spaziale, DAIR ha combinato immagini satellitari ad alta risoluzione e dati demografici con strumenti di ML per far emergere modelli di segregazione razziale ed economica radicati nel territorio. Elemento cruciale è stato il coinvolgimento di studenti locali di laurea magistrale, che hanno portato con sé conoscenze fondamentali e vissuti personali per identificare correttamente le township, garantendo l’accuratezza e la rilevanza dell’analisi. Anche in questo caso, però, è importante ricordare che la tecnologia, per quanto sofisticata o applicata con rigore, non può risolvere da sola le ingiustizie strutturali. Nel migliore dei casi, può contribuire a rivelare modelli nascosti e rafforzare le basi probatorie necessarie per rivendicare un cambiamento. Ma per trasformare queste evidenze in azione concreta servono volontà politica, impegno costante e azione collettiva. Il ML può rendere visibile l’ingiustizia, ma solo le persone — attraverso l’azione politica — possono affrontarla e trasformarla.

Per muoverci verso un futuro più giusto, dobbiamo resistere alla forza gravitazionale dell’hype sull’IA. I settori dello sviluppo e dell’umanitario non devono cedere i propri mandati a metriche riduttive dell’innovazione, ma rivendicare il linguaggio della democrazia e della solidarietà—valori radicati nell’intelligenza umana collettiva, non in quella artificiale. Abbiamo bisogno di autonomia, non automazione; di l’agentività (agency), non alienazione; di collaborazione, non isolamento; di dignità, non dominio; e di etica, non efficienza. Questi principi non sono solo alternative poetiche: sono ancore necessarie in un’epoca segnata da un tecno-utopismo fuori controllo.

Soprattutto, abbiamo bisogno di tecnologie dell’umiltà — metodi disciplinati che riconoscano la parzialità della conoscenza scientifica e ci aiutino ad agire in condizioni di incertezza. Queste “tecnologie” ci invitano a riflettere sull’ambiguità e la complessità, a porre domande migliori e a considerare epistemologie trascurate: modi di conoscere radicati nelle esperienze vissute, nei contesti culturali plurali e in quadri etici che non si rifanno a norme dominanti o esclusive, ma restano aperti e inclusivi nei confronti di visioni del mondo storicamente marginalizzate.

Immagini generate tramite ChatGPT. Tutti i diritti sono riservati. Università di Torino (2025).